先日、公開ドキュメントを参考にFessをインストールして色々な設定を行っているのですが

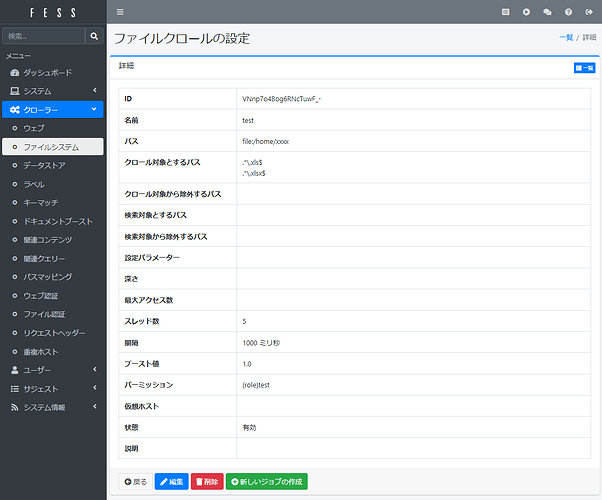

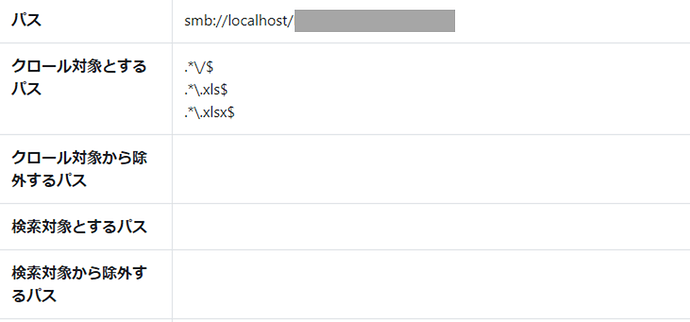

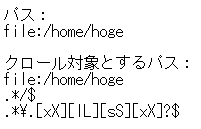

ファイルクロールのクロール対象とするパスに何かを指定するとクロールできなくなります。

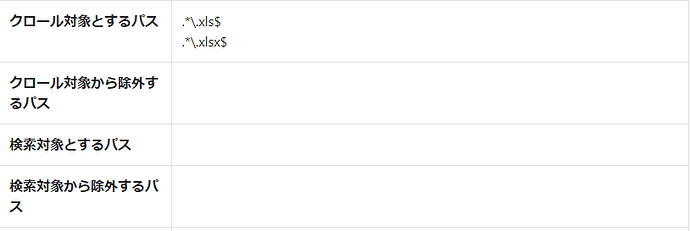

例えば、クロール対象から除外するパスに指定した正規表現の「..xls$」「..xlsx$」を

クロール対象とするパスに指定するとクロールできません。

なお、同じ正規表現をクロール対象から除外するパス、検索対象とするパス、検索対象から除外するパスに指定すると想定したとおりの動作になります。

クロールするファイル数を少なくしたいのでクロール対象とするパスにどのように指定したら良いのかご教示いただけたら幸いです。

◆使用環境

CentOS Stream release 8

Fess 14.13.0

OpenSearch 2.13.0

◆fess-crawler.log

2024-04-22 13:15:03,001 [main] INFO Starting Crawler…

2024-04-22 13:15:03,104 [WebFsCrawler] INFO Target Path: file:/home/xxxx

2024-04-22 13:15:03,106 [WebFsCrawler] INFO Included Path: ..xls$

2024-04-22 13:15:03,106 [WebFsCrawler] INFO Included Path: ..xlsx$

2024-04-22 13:15:13,120 [IndexUpdater] INFO Processing no docs in indexing queue (Doc:{access 2ms}, Mem:{used 143.176MB, heap 457.728MB, max 2.048GB})

2024-04-22 13:15:23,117 [IndexUpdater] INFO Processing no docs in indexing queue (Doc:{access 2ms}, Mem:{used 146.907MB, heap 457.728MB, max 2.048GB})

2024-04-22 13:15:33,117 [IndexUpdater] INFO Processing no docs in indexing queue (Doc:{access 2ms}, Mem:{used 149.615MB, heap 457.728MB, max 2.048GB})

2024-04-22 13:15:33,219 [WebFsCrawler] INFO [EXEC TIME] crawling time: 30185ms

2024-04-22 13:15:43,118 [IndexUpdater] INFO Processing no docs in indexing queue (Doc:{access 3ms}, Mem:{used 149.948MB, heap 457.728MB, max 2.048GB})

2024-04-22 13:15:43,118 [IndexUpdater] INFO [EXEC TIME] index update time: 14ms

2024-04-22 13:15:43,141 [main] INFO Finished Crawler

2024-04-22 13:15:43,158 [main] INFO [CRAWL INFO] CrawlerEndTime=2024-04-22T13:15:43.141+0900,WebFsCrawlExecTime=30185,CrawlerStatus=true,CrawlerStartTime=2024-04-22T13:15:03.001+0900,WebFsCrawlEndTime=2024-04-22T13:15:43.140+0900,WebFsIndexExecTime=14,WebFsIndexSize=0,CrawlerExecTime=40140,WebFsCrawlStartTime=2024-04-22T13:15:03.023+0900

2024-04-22 13:15:43,161 [main] INFO Disconnected to http://localhost:9200

2024-04-22 13:15:43,163 [main] INFO Destroyed LaContainer.